« Le marché de la veille d’opinion en ligne et du social listening a gagné en maturité », Jean-Christophe Gatuingt (Visibrain)

Auteur(s)

Date

Partager

Résumé

Entretien avec Jean-Christophe Gatuingt, co-fondateur de Visibrain, sur les bouleversements en cours sur les réseaux sociaux.

Auteur(s)

Date

Partager

Résumé

Entretien avec Jean-Christophe Gatuingt, co-fondateur de Visibrain, sur les bouleversements en cours sur les réseaux sociaux.

Nouvelle API Twitter, changement des règles de modération du réseau social à l’oiseau bleu, essor fulgurant de Tik Tok, innovations technologiques et social listening… Pour l’Observatoire Stratégique de l’Information, Jean-Christophe Gatuingt, co-fondateur de la plateforme de veille Visibrain, décrypte les bouleversements en cours dans le paysage des réseaux sociaux et leurs répercussions pour les veilleurs et les analystes de l’opinion en ligne.

OSI : Twitter a communiqué à la mi-août sur une nouvelle version de son interface de programmation applicative (API). Quelles vont être, selon vous, les avancées permises par ces changements pour les chercheurs, les veilleurs et les analystes de l’opinion ?

Jean-Christophe Gatuingt : Pour bien comprendre les enjeux autour de cette nouvelle version (v2), il faut rappeler le contexte : Twitter propose depuis quasiment toujours une API ouverte, permettant à la fois d’interagir avec le réseau, et d’analyser les données publiques qui y circulent. En avance sur son temps à l’époque, cette v1 n’avait pas beaucoup évolué ces dernières années.

Sur le volet « interaction avec la plateforme », Twitter s’était même froissé avec l’écosystème des développeurs, en restreignant fortement les possibilités pour des logiciels alternatifs aux clients officiels. En particulier, seuls Twitter.com, les applications mobiles officielles et TweetDeck bénéficiaient des nouveautés de la plateforme (comme la fonctionnalité de sondage par exemple), car elles n’étaient pas retranscrites sur l’API.

Sur le volet « data », Twitter a par contre structuré un business-model prospère pour l’écosystème,en rachetant notamment Gnip en 2014. Il subsistait cependant un hic : depuis le rachat, l’API de Gnip (payante, autorisant l’accès à des volumes importants, destinée aux entreprises) coexistait avec l’API originale de Twitter (gratuite, limitée en volume, destinée aux particuliers), ce qui apportait à la fois des inconvénients techniques et commerciaux.

D’une part, les équipes de Twitter devaient consacrer beaucoup de temps à maintenir et rendre cohérentes les deux APIs plutôt que de les améliorer. D’autre part, les deux modèles (API gratuite et API commerciale) étaient relativement cloisonnés (avec tout de même une première amélioration en 2017 avec l’introduction des « premium APIs » pour adresser les besoins intermédiaires).

Twitter envoie un signal positif fort à l’écosystème des développeurs.

Avec cette nouvelle version, Twitter met tout au propre sous la forme d’une seule API complète et à jour, et envoie ainsi un signal positif fort à l’écosystème des développeurs. C’est une très bonne nouvelle pour les outils de veille et leurs utilisateurs. Plus concrètement :

- Pour les particuliers, on peut espérer voir se développer à nouveau une multitude d’outils gratuits (ou à bas coût) complémentaires à Twitter.com/TweetDeck

- Pour les chercheurs, c’est un grand pas en avant. Avant, la seule possibilité qu’ils avaient pour obtenir un accès large aux données brutes était de s’abonner aux offres pour les entreprises, dont le tarif et les conditions d’utilisation n’étaient pas adaptés à leurs problématiques. Désormais, Twitter propose une nouvelle offre dédiée au monde de la recherche.

- Enfin, pour les professionnels de la veille & de l’analyse, c’est une assurance que les plateformes de veille réseaux sociaux continueront à bénéficier des données Twitter dans les meilleures conditions possibles, avec, je l’espère, des innovations à la clé. Par exemple, à sa sortie, l’API v2 contient côté data deux nouveautés : « tweet annotations » (contextualisation des tweets) et « conversation id » (regroupement plus efficace des conversations). C’est un début prometteur.

Twitter renforce dans le même temps ses dispositifs de modération des contenus et adopte une politique intraitable contre les comptes dits “sensibles”. Comment appréhender cette posture de Twitter ? La plateforme ne risque pas de devenir complètement aseptisée et de ressembler à LinkedIn, un réseau social sur lequel prévaut l’auto-censure ?

Jean-Christophe Gatuingt : Les plateformes réseaux sociaux font face à des problématiques de modération très complexes, puisqu’elles doivent composer entre liberté d’expression, sérénité des utilisateurs, lois des différents pays, sensibilités des différentes cultures, pressions politiques… Twitter en particulier est souvent accusé d’être un « réseau social toxique ». Des journalistes, célébrités ou influenceurs quittent encore régulièrement le réseau par ras le bol des trolls. A partir de là, cela me semble légitime et même sain que Twitter teste de nouveaux dispositifs.

Tant que Twitter ne fait pas de compromis sur le pseudonymat, il n’y a aucun risque qu’il devienne un LinkedIn-bis.

Twitter et LinkedIn sont des plateformes très différentes, et parmi les différences fondamentales, on trouve la possibilité du pseudonymat. Twitter permet à toute personne physique ou morale (entreprises, associations, projets, journalistes, professionnels, lanceurs d’alertes, victimes, minorités…) de prendre simplement la parole publiquement en s’adressant à une audience mondiale, sans avoir besoin de dévoiler son identité réelle. C’est une grande force de la plateforme (même si cela rend évidemment d’autant plus compliquées les problématiques de modération). Tant que Twitter ne fait pas de compromis là-dessus, il n’y a aucun risque qu’il devienne un LinkedIn-bis.

Ces annonces de Twitter ne sauraient occulter que le paysage des APIs est en pleine mutation. Va-t-on vers un mouvement de fermeture, à la manière de Facebook, échaudé en partie par différents scandales politiques, ou l’ouverture des données a-t-elle au contraire encore de l’avenir ?

Jean-Christophe Gatuingt : Ces mutations ne datent pas d’hier. Pour Facebook, les signes d’une politique de fermeture de données remontent à 2014, avec la suppression de la fonctionnalité « Search public posts » dans la version 2 de la « Graph API ». Cette politique est probablement motivée surtout par la volonté de ne pas partager les données (et les insights qui vont avec) avec des acteurs extérieurs. Ceci étant dit, la nature même de Facebook – où cercles privés et place publique s’entremêlent au sein d’une même plateforme – est moins propice à une ouverture des données que pour des réseaux comme Twitter ou YouTube. Bien évidemment, le scandale « Cambridge Analytica » en 2018 a renforcé la tendance.

Aujourd’hui, on distingue nettement deux philosophies :

- Les plateformes qui ont tendance à fermer leurs données publiques, comme Facebook, Instagram (racheté par Facebook) ou LinkedIn (racheté par Microsoft)

- Les plateformes qui ont tendance à ouvrir leurs données, en proposant une API correctement structurée pour permettre la recherche parmi les posts publics, voire en construisant un business-model autour de la revente des données. On peut citer Twitter bien évidemment, mais aussi Reddit, YouTube,Weibo (Chine) ou VKontakte (Russie).

Difficile de faire des prédictions sur ce sujet. Avec sa nouvelle API, Twitter continue de montrer une voie intéressante en structurant de mieux en mieux son business-model. Espérons que des plateformes comme TikTok s’en inspirent (pour l’instant, le site dédié aux développeurs TikTok est bien mince).

Alors que la science-fiction et le film Minority Report ont en partie façonné notre rapport aux réseaux sociaux, la tentation est parfois grande de promettre l’omniscience et même une capacité de prédiction des phénomènes d’opinion à coup de surenchère technologique. Est-il encore possible de tenir un discours mesuré sur ce qui est observable ou non sur les réseaux sociaux, sur ce qui est réaliste ou utopique ?

Jean-Christophe Gatuingt : Il est vrai qu’il y a eu une période où certains promettaient une révolution de l’analyse de l’opinion grâce à un accès sans filtre et temps-réel à la voix des consommateurs via les réseaux sociaux. Depuis l’ensemble du marché a gagné en maturité : les professionnels du secteur ne se laissent plus berner par une surenchère au nombre de sources, mais cherchent plutôt à comprendre précisément quelles sont les données observables sur chacune d’entre elles. Ils sont de plus en plus conscients qu’en réalité, avec les outils de veille des réseaux sociaux, on accède principalement à la voix des médias et des influenceurs, et qu’on peut seulement « deviner » ainsi l’opinion.

Les algorithmes permettent de faire gagner du temps aux veilleurs et aux analystes, pas de les remplacer.

À défaut d’omniscience, les outils de veille réseaux sociaux permettent d’obtenir instantanément une photographie partielle des tendances et des signaux faibles, ce qui est déjà considérable ! Ils ne remplacent pas mais complètent les études traditionnelles, les deux se nourrissant mutuellement. En ce moment, beaucoup de promesses sont faites autour de l’intelligence artificielle, alors qu’il faut à mon avis rappeler avant tout l’importance de l’intelligence humaine dans un processus d’analyse des réseaux sociaux… Seul un veilleur/analyste apporte méthodologie, intuition et interprétation ; les algorithmes de l’outil permettent de lui faire gagner du temps, pas de le remplacer.

Ces dernières semaines on a beaucoup parlé de TikTok, notamment Outre-Atlantique avec la volonté de Donald Trump de bannir le réseau social chinois, sur fond de tractations commerciales autour d’une volonté de rachat par Microsoft puis, plus récemment, par Oracle. Pourquoi ce réseau social suscite-t-il un tel engouement, ainsi que de telles craintes ? De quelle manière peut-il être utilisé pour analyser l’opinion ?

Jean-Christophe Gatuingt : La raison de l’engouement autour de TikTok est simple : sa croissance fulgurante ! Non seulement elle n’a pas stagné depuis le rebranding de Musical.ly en août 2018, mais elle a au contraire accéléré, avec un point d’orgue pendant le confinement début 2020 où la plateforme a réussi à toucher un nouveau public, partout dans le monde, au-delà de la cible initiale des adolescents. En France, nous estimons aujourd’hui l’audience de TikTok à plus de 10 millions d’utilisateurs, au même niveau que Snapchat.

Pour la première fois, un réseau social massivement utilisé dans le monde occidental provient de Chine (et non pas de la Silicon Valley), d’où l’apparition de différentes craintes. Elles sont plus ou moins justifiées, mais il est vrai que TikTok n’est pas exempt de tout reproche puisque la plateforme a été accusée à plusieurs reprises de s’adonner à de la censure politique et de supprimer les comptes d’utilisateurs « laids », pauvres, handicapés ou homosexuels. Aussi, l’application collecterait des données sur ses utilisateurs de manière plus agressive que les autres réseaux sociaux, en ayant notamment exploité par le passé des failles de sécurité sur les systèmes d’exploitation mobiles Android et iOS pour accéder à des données normalement inaccessibles.

Concernant l’analyse de l’opinion, TikTok pourrait devenir une plateforme intéressante si elle se transforme en « Twitter de la vidéo ». Le potentiel est là, avec un format innovant, un écosystème grandissant d’influenceurs, un contenu de plus en plus diversifié… Il y a eu un avant et un après #BlackLivesMatter, où TikTok s’est révélé un des principaux lieux d’expression sur le sujet. A l’heure actuelle, il est encore un peu tôt pour donner plus d’éléments, mais Visibrain travaille sur un module de veille TikTok (NDLR : à découvrir prochainement sur le site de Visibrain) qui devrait sortir dans quelques mois. Nous aurons plus de recul sur les enseignements qu’il est possible d’en tirer à ce moment-là !

Nouvelle API Twitter, changement des règles de modération du réseau social à l’oiseau bleu, essor fulgurant de Tik Tok, innovations technologiques et social listening… Pour l’Observatoire Stratégique de l’Information, Jean-Christophe Gatuingt, co-fondateur de la plateforme de veille Visibrain, décrypte les bouleversements en cours dans le paysage des réseaux sociaux et leurs répercussions pour les veilleurs et les analystes de l’opinion en ligne.

OSI : Twitter a communiqué à la mi-août sur une nouvelle version de son interface de programmation applicative (API). Quelles vont être, selon vous, les avancées permises par ces changements pour les chercheurs, les veilleurs et les analystes de l’opinion ?

Jean-Christophe Gatuingt : Pour bien comprendre les enjeux autour de cette nouvelle version (v2), il faut rappeler le contexte : Twitter propose depuis quasiment toujours une API ouverte, permettant à la fois d’interagir avec le réseau, et d’analyser les données publiques qui y circulent. En avance sur son temps à l’époque, cette v1 n’avait pas beaucoup évolué ces dernières années.

Sur le volet « interaction avec la plateforme », Twitter s’était même froissé avec l’écosystème des développeurs, en restreignant fortement les possibilités pour des logiciels alternatifs aux clients officiels. En particulier, seuls Twitter.com, les applications mobiles officielles et TweetDeck bénéficiaient des nouveautés de la plateforme (comme la fonctionnalité de sondage par exemple), car elles n’étaient pas retranscrites sur l’API.

Sur le volet « data », Twitter a par contre structuré un business-model prospère pour l’écosystème,en rachetant notamment Gnip en 2014. Il subsistait cependant un hic : depuis le rachat, l’API de Gnip (payante, autorisant l’accès à des volumes importants, destinée aux entreprises) coexistait avec l’API originale de Twitter (gratuite, limitée en volume, destinée aux particuliers), ce qui apportait à la fois des inconvénients techniques et commerciaux.

D’une part, les équipes de Twitter devaient consacrer beaucoup de temps à maintenir et rendre cohérentes les deux APIs plutôt que de les améliorer. D’autre part, les deux modèles (API gratuite et API commerciale) étaient relativement cloisonnés (avec tout de même une première amélioration en 2017 avec l’introduction des « premium APIs » pour adresser les besoins intermédiaires).

Twitter envoie un signal positif fort à l’écosystème des développeurs.

Avec cette nouvelle version, Twitter met tout au propre sous la forme d’une seule API complète et à jour, et envoie ainsi un signal positif fort à l’écosystème des développeurs. C’est une très bonne nouvelle pour les outils de veille et leurs utilisateurs. Plus concrètement :

- Pour les particuliers, on peut espérer voir se développer à nouveau une multitude d’outils gratuits (ou à bas coût) complémentaires à Twitter.com/TweetDeck

- Pour les chercheurs, c’est un grand pas en avant. Avant, la seule possibilité qu’ils avaient pour obtenir un accès large aux données brutes était de s’abonner aux offres pour les entreprises, dont le tarif et les conditions d’utilisation n’étaient pas adaptés à leurs problématiques. Désormais, Twitter propose une nouvelle offre dédiée au monde de la recherche.

- Enfin, pour les professionnels de la veille & de l’analyse, c’est une assurance que les plateformes de veille réseaux sociaux continueront à bénéficier des données Twitter dans les meilleures conditions possibles, avec, je l’espère, des innovations à la clé. Par exemple, à sa sortie, l’API v2 contient côté data deux nouveautés : « tweet annotations » (contextualisation des tweets) et « conversation id » (regroupement plus efficace des conversations). C’est un début prometteur.

Twitter renforce dans le même temps ses dispositifs de modération des contenus et adopte une politique intraitable contre les comptes dits “sensibles”. Comment appréhender cette posture de Twitter ? La plateforme ne risque pas de devenir complètement aseptisée et de ressembler à LinkedIn, un réseau social sur lequel prévaut l’auto-censure ?

Jean-Christophe Gatuingt : Les plateformes réseaux sociaux font face à des problématiques de modération très complexes, puisqu’elles doivent composer entre liberté d’expression, sérénité des utilisateurs, lois des différents pays, sensibilités des différentes cultures, pressions politiques… Twitter en particulier est souvent accusé d’être un « réseau social toxique ». Des journalistes, célébrités ou influenceurs quittent encore régulièrement le réseau par ras le bol des trolls. A partir de là, cela me semble légitime et même sain que Twitter teste de nouveaux dispositifs.

Tant que Twitter ne fait pas de compromis sur le pseudonymat, il n’y a aucun risque qu’il devienne un LinkedIn-bis.

Twitter et LinkedIn sont des plateformes très différentes, et parmi les différences fondamentales, on trouve la possibilité du pseudonymat. Twitter permet à toute personne physique ou morale (entreprises, associations, projets, journalistes, professionnels, lanceurs d’alertes, victimes, minorités…) de prendre simplement la parole publiquement en s’adressant à une audience mondiale, sans avoir besoin de dévoiler son identité réelle. C’est une grande force de la plateforme (même si cela rend évidemment d’autant plus compliquées les problématiques de modération). Tant que Twitter ne fait pas de compromis là-dessus, il n’y a aucun risque qu’il devienne un LinkedIn-bis.

Ces annonces de Twitter ne sauraient occulter que le paysage des APIs est en pleine mutation. Va-t-on vers un mouvement de fermeture, à la manière de Facebook, échaudé en partie par différents scandales politiques, ou l’ouverture des données a-t-elle au contraire encore de l’avenir ?

Jean-Christophe Gatuingt : Ces mutations ne datent pas d’hier. Pour Facebook, les signes d’une politique de fermeture de données remontent à 2014, avec la suppression de la fonctionnalité « Search public posts » dans la version 2 de la « Graph API ». Cette politique est probablement motivée surtout par la volonté de ne pas partager les données (et les insights qui vont avec) avec des acteurs extérieurs. Ceci étant dit, la nature même de Facebook – où cercles privés et place publique s’entremêlent au sein d’une même plateforme – est moins propice à une ouverture des données que pour des réseaux comme Twitter ou YouTube. Bien évidemment, le scandale « Cambridge Analytica » en 2018 a renforcé la tendance.

Aujourd’hui, on distingue nettement deux philosophies :

- Les plateformes qui ont tendance à fermer leurs données publiques, comme Facebook, Instagram (racheté par Facebook) ou LinkedIn (racheté par Microsoft)

- Les plateformes qui ont tendance à ouvrir leurs données, en proposant une API correctement structurée pour permettre la recherche parmi les posts publics, voire en construisant un business-model autour de la revente des données. On peut citer Twitter bien évidemment, mais aussi Reddit, YouTube,Weibo (Chine) ou VKontakte (Russie).

Difficile de faire des prédictions sur ce sujet. Avec sa nouvelle API, Twitter continue de montrer une voie intéressante en structurant de mieux en mieux son business-model. Espérons que des plateformes comme TikTok s’en inspirent (pour l’instant, le site dédié aux développeurs TikTok est bien mince).

Alors que la science-fiction et le film Minority Report ont en partie façonné notre rapport aux réseaux sociaux, la tentation est parfois grande de promettre l’omniscience et même une capacité de prédiction des phénomènes d’opinion à coup de surenchère technologique. Est-il encore possible de tenir un discours mesuré sur ce qui est observable ou non sur les réseaux sociaux, sur ce qui est réaliste ou utopique ?

Jean-Christophe Gatuingt : Il est vrai qu’il y a eu une période où certains promettaient une révolution de l’analyse de l’opinion grâce à un accès sans filtre et temps-réel à la voix des consommateurs via les réseaux sociaux. Depuis l’ensemble du marché a gagné en maturité : les professionnels du secteur ne se laissent plus berner par une surenchère au nombre de sources, mais cherchent plutôt à comprendre précisément quelles sont les données observables sur chacune d’entre elles. Ils sont de plus en plus conscients qu’en réalité, avec les outils de veille des réseaux sociaux, on accède principalement à la voix des médias et des influenceurs, et qu’on peut seulement « deviner » ainsi l’opinion.

Les algorithmes permettent de faire gagner du temps aux veilleurs et aux analystes, pas de les remplacer.

À défaut d’omniscience, les outils de veille réseaux sociaux permettent d’obtenir instantanément une photographie partielle des tendances et des signaux faibles, ce qui est déjà considérable ! Ils ne remplacent pas mais complètent les études traditionnelles, les deux se nourrissant mutuellement. En ce moment, beaucoup de promesses sont faites autour de l’intelligence artificielle, alors qu’il faut à mon avis rappeler avant tout l’importance de l’intelligence humaine dans un processus d’analyse des réseaux sociaux… Seul un veilleur/analyste apporte méthodologie, intuition et interprétation ; les algorithmes de l’outil permettent de lui faire gagner du temps, pas de le remplacer.

Ces dernières semaines on a beaucoup parlé de TikTok, notamment Outre-Atlantique avec la volonté de Donald Trump de bannir le réseau social chinois, sur fond de tractations commerciales autour d’une volonté de rachat par Microsoft puis, plus récemment, par Oracle. Pourquoi ce réseau social suscite-t-il un tel engouement, ainsi que de telles craintes ? De quelle manière peut-il être utilisé pour analyser l’opinion ?

Jean-Christophe Gatuingt : La raison de l’engouement autour de TikTok est simple : sa croissance fulgurante ! Non seulement elle n’a pas stagné depuis le rebranding de Musical.ly en août 2018, mais elle a au contraire accéléré, avec un point d’orgue pendant le confinement début 2020 où la plateforme a réussi à toucher un nouveau public, partout dans le monde, au-delà de la cible initiale des adolescents. En France, nous estimons aujourd’hui l’audience de TikTok à plus de 10 millions d’utilisateurs, au même niveau que Snapchat.

Pour la première fois, un réseau social massivement utilisé dans le monde occidental provient de Chine (et non pas de la Silicon Valley), d’où l’apparition de différentes craintes. Elles sont plus ou moins justifiées, mais il est vrai que TikTok n’est pas exempt de tout reproche puisque la plateforme a été accusée à plusieurs reprises de s’adonner à de la censure politique et de supprimer les comptes d’utilisateurs « laids », pauvres, handicapés ou homosexuels. Aussi, l’application collecterait des données sur ses utilisateurs de manière plus agressive que les autres réseaux sociaux, en ayant notamment exploité par le passé des failles de sécurité sur les systèmes d’exploitation mobiles Android et iOS pour accéder à des données normalement inaccessibles.

Concernant l’analyse de l’opinion, TikTok pourrait devenir une plateforme intéressante si elle se transforme en « Twitter de la vidéo ». Le potentiel est là, avec un format innovant, un écosystème grandissant d’influenceurs, un contenu de plus en plus diversifié… Il y a eu un avant et un après #BlackLivesMatter, où TikTok s’est révélé un des principaux lieux d’expression sur le sujet. A l’heure actuelle, il est encore un peu tôt pour donner plus d’éléments, mais Visibrain travaille sur un module de veille TikTok (NDLR : à découvrir prochainement sur le site de Visibrain) qui devrait sortir dans quelques mois. Nous aurons plus de recul sur les enseignements qu’il est possible d’en tirer à ce moment-là !

Quels sont les ressorts objectifs et quantifiables à l’origine de cette volonté de réguler les réseaux sociaux ?

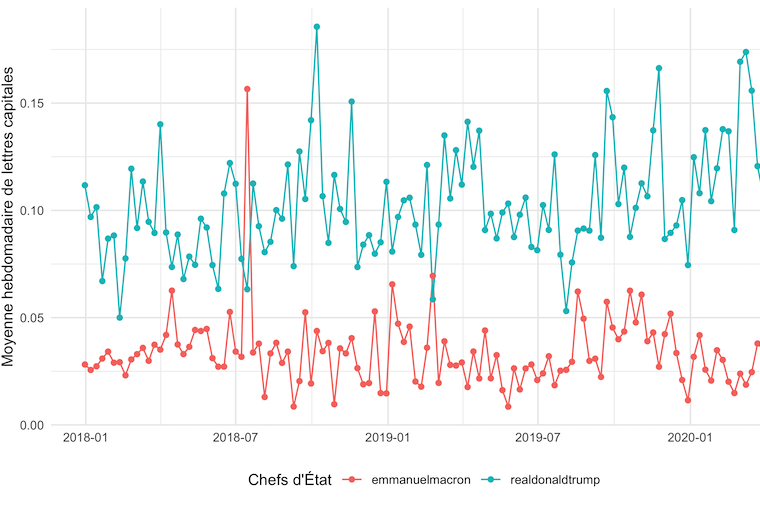

Création d’un modèle de classification de tweets basé sur l’utilisation des lettres capitales dans une série de publications.

On s’inquiéterait, à juste titre, qu’un juriste puisse discourir doctement sans jamais avoir lu la moindre ligne d’un code civil ou pénal. Mais on ne s’inquiète pas d’une telle situation, tout aussi affligeante, dans l’univers des médias et de la communication.

Il est à soupçonner fortement que le confinement dans sa première version, que nous décrivions dans sa phase terminale comme un « problème moral et politique », a probablement débuté sa carrière sur le marché des solutions politiques, de manière souterraine dans le domaine de la mystique, et s’y tiendra tapis à chaque accalmie, attendant son heure pour ressurgir comme un vampire.